2025-06-26 13:12:02来源:sxtmmc 编辑:佚名

deepseek,作为一款由杭州深度求索人工智能基础技术研究有限公司开发的人工智能平台,专注于大语言模型(llms)的研发与应用,因其强大的功能和便捷的操作而广受用户欢迎。本文将详细介绍如何在本地部署deepseek,让感兴趣的用户能够轻松上手。

在进行deepseek本地部署之前,我们需要确保计算机满足一定的软硬件要求。

操作系统:windows 10/11、macos 10.14+、ubuntu 20.03+。

硬件要求:

* cpu:4核+

* 内存:16gb+

* gpu:显存4g+(推荐使用nvidia显卡,并确保安装了cuda toolkit)

* 存储:30gb+

软件依赖:python 3.9+、git。

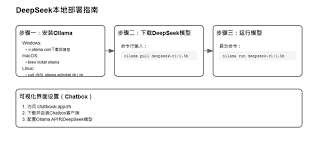

ollama是运行deepseek模型的必要环境。以下是安装ollama的步骤:

1. 访问ollama官网:前往ollama官网,点击“download”按钮。

2. 下载安装包:根据操作系统选择对应的安装包。windows用户可以直接下载exe安装文件,macos和linux用户可以通过命令行安装。

3. 安装ollama:双击下载的安装包并按照提示完成安装。在安装过程中,请确保选择了正确的安装路径,并预留足够的磁盘空间。

4. 验证安装:安装完成后,在命令行中输入`ollama -v`(windows用户可以使用`ollama -v`或`ollama --version`),如果显示版本号,则说明安装成功。

在成功安装ollama后,接下来需要下载并部署deepseek模型。以下是具体步骤:

1. 访问deepseek模型库:在浏览器中访问ollama官网的deepseek模型库页面。

2. 选择模型版本:根据自己的硬件配置和需求选择合适的deepseek模型版本。入门级用户可以选择1.5b版本,中端用户可以选择7b或8b版本,高性能用户可以选择14b、32b或70b版本。

3. 下载并运行模型:在命令行中输入对应的命令下载并运行deepseek模型。例如,下载并运行7b版本的命令为`ollama run deepseek-r1:7b`。其他版本的命令类似,只需将版本号替换为所需的版本即可。

在成功部署deepseek模型后,可以通过命令行与模型进行交互测试。以下是测试步骤:

1. 进入交互模式:在命令行中输入对应的命令进入deepseek模型的交互模式。例如,如果运行的是7b版本,则输入`ollama run deepseek-r1:7b`并按回车。

2. 与模型对话:在交互模式下,可以输入问题与模型进行对话。例如,输入“你好,请用中文回答”,模型将回复“你好!我是deepseek-r1,很高兴为您提供帮助!”。

虽然命令行交互方式简单直接,但界面不够美观,交互性也不够强。为了增强用户体验,可以使用第三方客户端,如chatbox或open webui。

使用chatbox:

1. 下载安装chatbox:访问chatbox官网并下载安装包。支持windows、macos、linux和安卓系统。

2. 配置deepseek模型:打开chatbox并进入设置选项,在模型提供方选择ollama api,api域名中填写`http://localhost:11434`(ollama的默认端口),模型名称填写与部署的deepseek模型版本一致的名称。

3. 开始对话:配置完成后,即可在chatbox中与deepseek模型进行对话。

使用open webui:

1. 安装docker:如果尚未安装docker,请从docker官网下载并安装。

2. 运行open webui:在命令行中输入docker运行命令启动open webui。例如:`docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main`。

3. 访问webui界面:打开浏览器并访问`http://localhost:3000/`进入open webui界面。首次使用需要注册管理员账号。

4. 配置deepseek模型:登录后,进入模型管理页面,选择“添加本地模型”,并填写模型名称和运行命令。保存设置后,在主界面点击对应模型即可开始与模型对话。

通过以上步骤,您已经成功在本地部署了deepseek模型,并可以使用命令行或第三方客户端与模型进行交互。希望这篇文章能够帮助您更好地了解deepseek的本地部署过程,享受人工智能带来的便捷与乐趣。